Weniger überzeugend finde ich in dem Whitepaper den Brückenschlag von Data Science & Analytics zu PLM. Dass PLM angeblich ein besonders interessantes Einsatzgebiet ist, weil PLM-Plattformen ein Sammelpunkt für riesige Datenmenge sei, wird lediglich mit dem dürren Hinweis auf den digitalen Zwilling bzw. die Möglichkeit, IoT-Geräte über die Cloud an PLM anzubinden, untermauert. Hier hätte man gerne mehr erfahren, wie genau die neuen Möglichkeiten der Datenanalyse in die PLM-Architektur eingebunden werden sollen. Ich vermute mal, dass sie als Bestandteil von CONTACT Elements for IoT in der Cloud bereitgestellt werden sollen, denn es macht wenig Sinn, riesige Datenmengen erst mal in die Cloud zu schicken und dann für die Analyse auf eine lokal installierte PLM-Plattform runterzuladen. Die schlauen Algorithmen für die Analyse werden da gebraucht, wo die Daten entstehen, insbesondere wenn es sich um Daten handelt, die in Echtzeit ausgewertet werden sollen, um z.B. die Produktion im laufenden Betrieb zu optimieren.

Interessiert hätte mich in diesem Zusammenhang auch die Frage, was KI-basierte Analysemethoden leisten können, um die klassischen PLM-Daten zu bereinigen, zu vervollständigen, automatisch zu klassifizieren oder semantische Beziehungen zwischen verschiedenen Informationsobjekten herzustellen. Das ist gerade mit Blick auf den Einsatz von Werkzeugen und Methoden des Model Based Systems Engineerings (MBSE) ein viel diskutiertes Thema, weil die manuelle Verknüpfung von Anforderungen, Funktionen, Bauteilen, Test Cases etc. bei größeren Produkten viel zu aufwendig ist.

In den PLM-Systemen steckt heute eine riesige Menge an (strukturierten) Daten, die genutzt werden könnten, um Management-Entscheidungen abzusichern oder Continuous Improvement-Initiativen zu unterstützen. Leider werden sie kaum ausgewertet, obwohl dafür nicht mal besonders intelligente Algorithmen erforderlich wären. Das wäre meines Erachtens der erste Schritt in die Welt der Data Science & Analtics, bevor wir uns die Auswertung von unstrukturierten Big Data aus dem IoT herantasten.

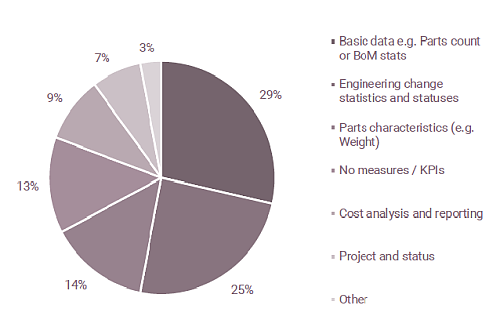

Der Marktstudie PLMPulse Survey 2017 zufolge leiten 66 Prozent der Unternehmen keine oder nur rudimentäre Key Performance-Indikatoren (KPI) aus ihren PLM-Informationen ab. Nur 25 Prozent der Befragten wertet z.B. die Informationen über Engineering Changes aus, aus denen sich wertvolle Anregungen für Prozessverbesserungen ableiten lassen. Zum Teil hängt das damit zusammenhängt, dass die Informationen schwer zugänglich sind oder für die Analyse exportiert werden müssen. Nur 19 Prozent der Unternehmen nutzen dafür die von ihren PLM-Herstellern bereitgestellten Analyse-Tools und weitere 15 Prozent werten die Daten direkt mit Third-Party-Tools aus. Mit anderen Worten, die meisten Unternehmen machen zu wenig aus ihren PLM-Informationen. Da nimmt es nicht Wunder, dass der Nutzen von PLM für die Mehrzahl nicht greifbar ist.